Ai之大模型进阶模型微调-Unsloth微调-实战5.2

发布时间:2025-03-20 10:42:40编辑:123阅读(1953)

在之前的文章中学习了如何使用 Ollama 运行 Ollama 平台上的开源模型,其实 Ollama 也是可以支持直接从 Hugging Face 上拉取并运行模型了,所以可以把刚刚训练好的模型上传到 Hugging Face 上。

GGUF 是一种高效的格式,它支持多种量化方法(如 4 位、8 位、16 位量化),可以显著减小模型文件的大小,便于存储和传输,适合在资源受限的设备上运行模型,例如在 Ollama 上部署时。量化后的模型在资源受限的设备上运行更快,适合边缘设备或低功耗场景。

将微调后的模型保存为 GGUF 格式,将微调后的模型上传到huggingface。

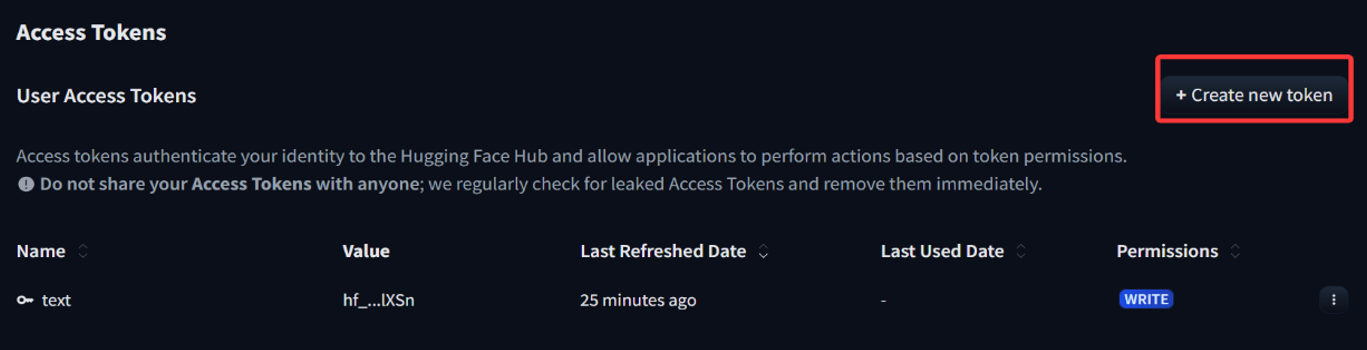

登录huggingface,可以到 HuggingFace 的 Settings - Access Tokens 下创建一个自己的 Token。

注意一定要配置位写权限,不然后面没有权限创建仓库。

创建好后,复制token就好了

代码如下:

# 将模型保存为8位量化格式(Q8_0)

# 8 位量化这种格式小且运行快,适合部署到资源受限的设备

if True:model.save_pretrained_gguf("model", tokenizer)

# 将模型保存为16位量化格式(f16)

# 16 位量化精度更高,但文件稍大

if False:model.save_pretrained_gguf("model", tokenizer, quantization_method = "f16")

# 将模型保存为4位量化格式(q4_k_m)

# 4 位量化文件最小,但精度可能稍低

if False:model.save_pretrained_gguf("model", tokenizer, quantization_method = "q4_k_m")

# 用于创建一个新的模型仓库

from huggingface_hub import create_repo

model_name = 'SamTaoQaq/suanming'

huggingface_hub_token = 'hf_zslflzYDYnUSZGXSKbmDFQSemAXLFPxxxx'

# 在hugging face hub上创建一个新的模型仓库

create_repo(model_name, token=huggingface_hub_token, exist_ok=True)

# 将模型和分词器上传到hugging face hub上的仓库

model.push_to_hub_gguf(model_name, tokenizer,token=huggingface_hub_token)结果如下:

复制地址:https://huggingface.co/SamTaoQaq/suanming

去Hugging Face上查看一下:

使用Ollama运行HuggingFace模型

ollama支持直接从Huggingface拉去模型,格式如下:

ollama run hf.co/SamTaoQaq/suanming

如下:

上一篇: Ai之大模型进阶模型微调-Unsloth微调-实战5.1

下一篇: OCR使用深度学习识别图形验证码

- openvpn linux客户端使用

51709

- H3C基本命令大全

51368

- openvpn windows客户端使用

41801

- H3C IRF原理及 配置

38574

- Python exit()函数

33051

- openvpn mac客户端使用

30067

- python全系列官方中文文档

28733

- python 获取网卡实时流量

23729

- 1.常用turtle功能函数

23643

- python 获取Linux和Windows硬件信息

22010

- Python搭建一个RAG系统(分片/检索/召回/重排序/生成)

2224°

- Browser-use:智能浏览器自动化(Web-Agent)

2911°

- 使用 LangChain 实现本地 Agent

2432°

- 使用 LangChain 构建本地 RAG 应用

2372°

- 使用LLaMA-Factory微调大模型的function calling能力

2943°

- 复现一个简单Agent系统

2375°

- LLaMA Factory-Lora微调实现声控语音多轮问答对话-1

3177°

- LLaMA Factory微调后的模型合并导出和部署-4

5233°

- LLaMA Factory微调模型的各种参数怎么设置-3

5046°

- LLaMA Factory构建高质量数据集-2

3607°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江