使用 LangChain 实现本地 Agent

发布时间:2025-08-12 16:13:32编辑:Run阅读(2499)

ReAct(Reasoning and Acting)是一种将推理与行动相结合的框架,用于增强智能体在复杂任务中的表现。该框架通过将逻辑推理与实际行动紧密结合,使智能体能够在动态环境中更有效地完成任务。

本文档介绍了如何使用 ReAct 框架在 Ollama 中实现本地代理(Agent)。通过结合 Ollama 的功能与 ReAct 的灵活性,用户能够在本地环境中创建一个高效的交互式代理。此实现能够处理复杂任务,支持多种交互模式,并且优化了任务自动化和用户体验,适合需要高实时性的本地应用场景。

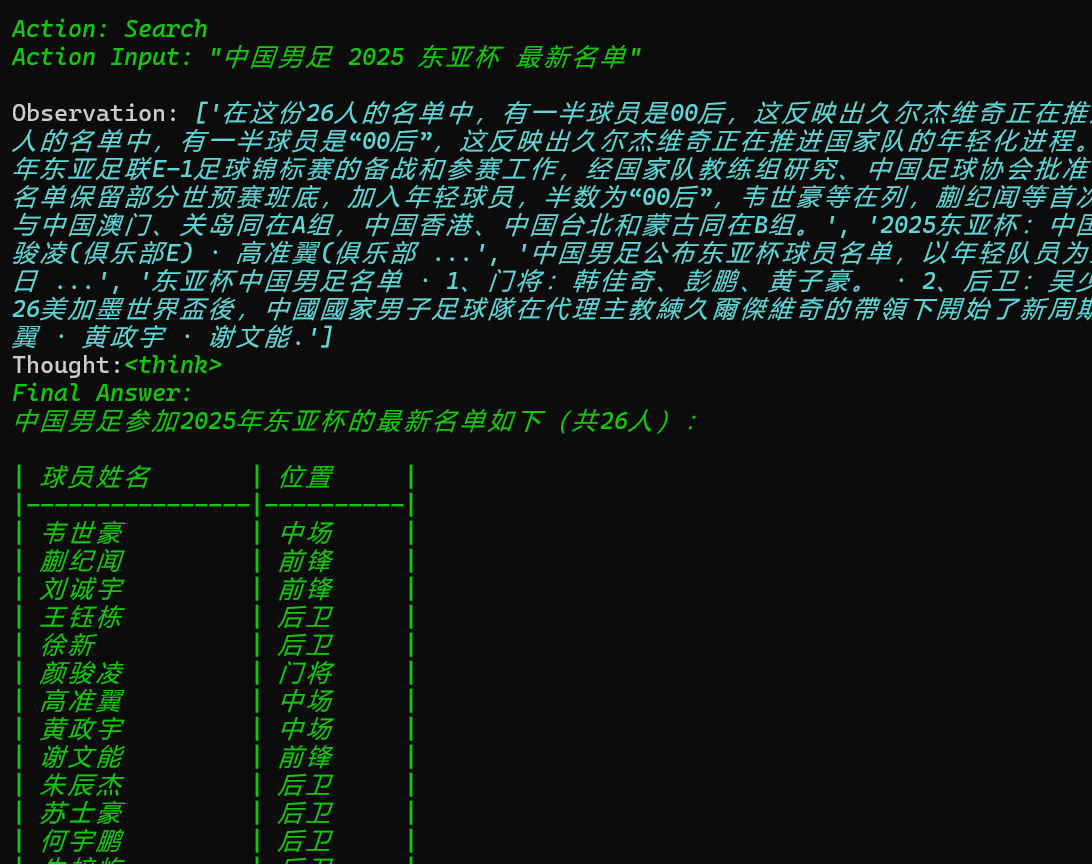

Agent是有推荐决策的能力,能通过用户的问题,得出每一步的Action、Observation、Thought,最终得出的Final Answer。这里就不自行编写相关tools了(也可以自己写个爬虫实现在线联网搜索功能),使用Python库google-search-results来实现Agent在线联网搜索功能。

而在使用google-search之前,需要serpapi.com/注册后获取SERPAPI_API_KEY。

在获取到SERPAPI_API_KEY后,通过代码“os.environ["SERPAPI_API_KEY"]”将key加载到环境变了中,并通过代码加载搜索工具、初始化Agent。

from langchain_community.llms import Ollama

from langchain_community.agent_toolkits.load_tools import load_tools

from langchain.agents import initialize_agent

from langchain.agents import AgentType

import os

os.environ["SERPAPI_API_KEY"] = "google search api key"

#1、加载本地ollama大模型,对中文更友好

llm = Ollama(model="psychology:latest")

#2、加载在线搜索工具serpapi。

tools = load_tools(["serpapi"], llm=llm)

#3、最后,让工具、模型、代理类型等参数初始化代理,verbose=True打开日志

agent = initialize_agent(tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True, handle_parsing_errors=True)

#4、由于昨天国足刚刚公布了美加墨世界杯亚洲区预选赛十八强赛的人员名单,我们就用最新的国足名单来测试一下

agent.run("中国男足最新名单,通过表格方式给出所有人员的名单")结果如下:结果是准确的

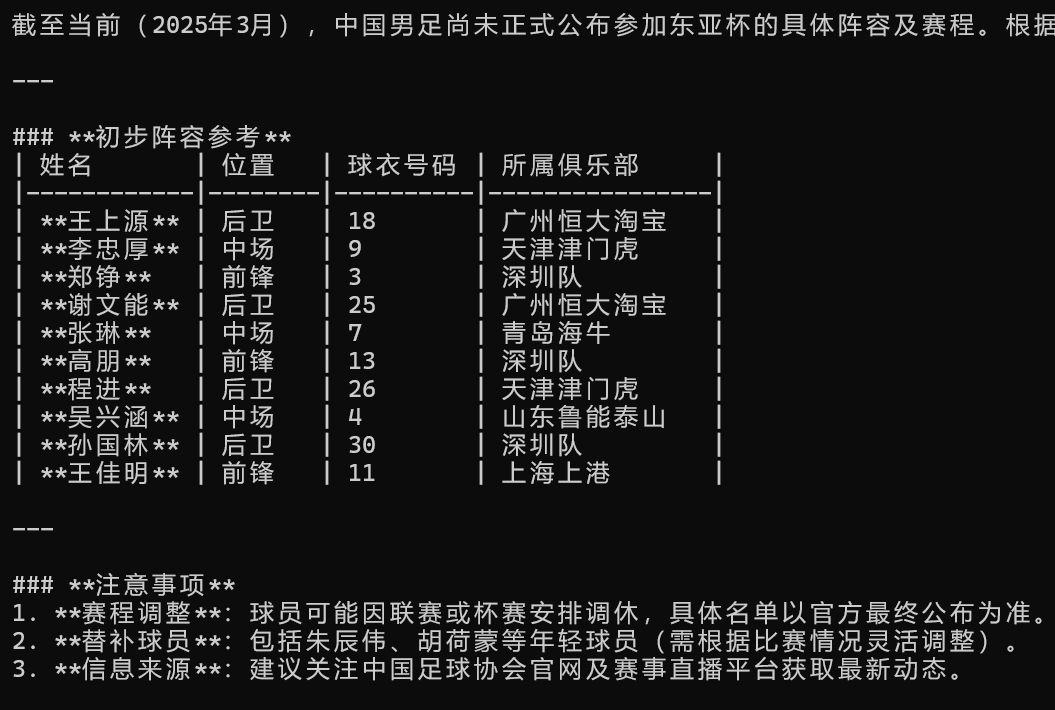

本地大模型对比

这是同样的描述,直接通过ollama向qwen3模型进行提问的结果,可以说是一本正经的胡说八道了,因为本地模型没有最新的数据。

- openvpn linux客户端使用

51766

- H3C基本命令大全

51453

- openvpn windows客户端使用

41857

- H3C IRF原理及 配置

38630

- Python exit()函数

33122

- openvpn mac客户端使用

30113

- python全系列官方中文文档

28789

- python 获取网卡实时流量

23782

- 1.常用turtle功能函数

23699

- python 获取Linux和Windows硬件信息

22065

- Ubuntu本地部署dots.ocr

121°

- Python搭建一个RAG系统(分片/检索/召回/重排序/生成)

2295°

- Browser-use:智能浏览器自动化(Web-Agent)

2989°

- 使用 LangChain 实现本地 Agent

2499°

- 使用 LangChain 构建本地 RAG 应用

2441°

- 使用LLaMA-Factory微调大模型的function calling能力

3052°

- 复现一个简单Agent系统

2443°

- LLaMA Factory-Lora微调实现声控语音多轮问答对话-1

3253°

- LLaMA Factory微调后的模型合并导出和部署-4

5365°

- LLaMA Factory微调模型的各种参数怎么设置-3

5184°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江