python爬虫--调用百度翻译进行文本翻译

发布时间:2017-11-28 21:22:26编辑:Run阅读(6692)

python爬虫实现百度译文本

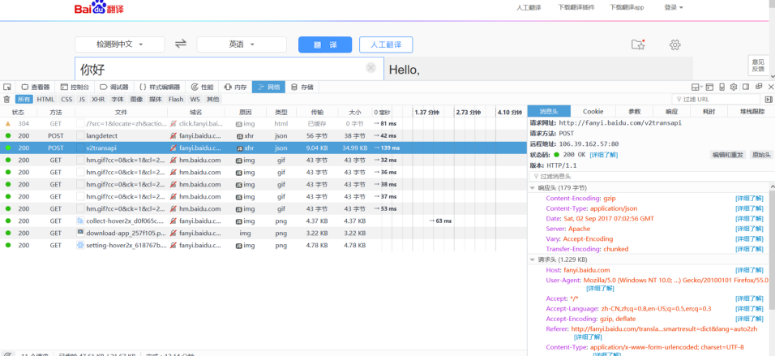

打开百度翻译网站地址,F12审查元素,我这里用的是火狐浏览器

点网络,会发现很多GET,POST请求,右边消息头那里会有很多信息:请求地址、请求方法、远程地址、状态码、server、等等之类的信息

这里的请求地址才是翻译的实际地址,看上图

在客户端和服务器之间进行请求,响应的时候,两种最常用的方法就是get,post

get:定义上来说,是指向服务器请求获得数据

post:是向指定服务器提交被处理的数据

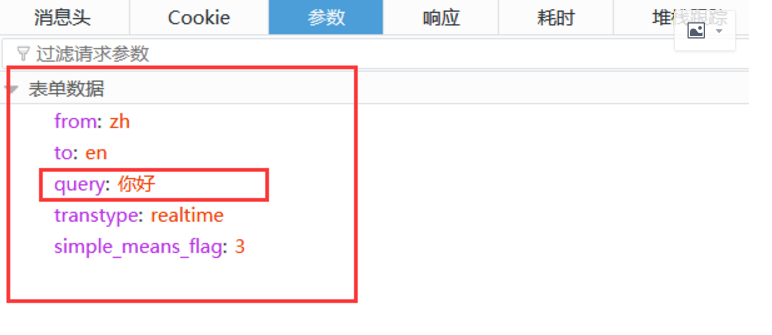

点开一个post请求看看里面的内容

里面会有一些表单数据,query:你好,这个你好就是我们刚刚输入翻译的内容,有了这些信息,我们就可以写爬虫调用了

代码如下

#!/usr/bin/env python

# coding: utf-8

__author__ = 'www.py3study.com'

import urllib.request #导入urllib.request模块

import urllib.parse #导入urllib.parse这个是用来解析的

import json # json 为轻量级的数据交换格式

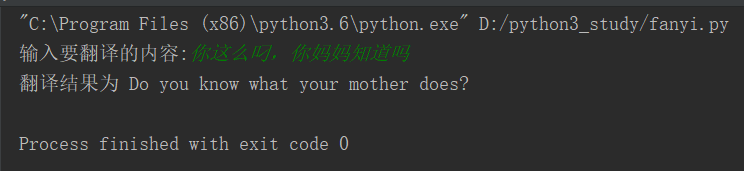

input_shuru = input('输入要翻译的内容:') #输入要翻译的内容

url = 'https://fanyi.baidu.com/v2transapi' #实际翻译地址

webheaders = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0'}

# 模拟火狐浏览器访问

headers = webheaders # headers 请求消息头,上面设置了一个浏览器消息头,直接调用

req = urllib.request.Request(url,headers) #加上url,headers构成一个完整的访问请求

data = {} #data 是一个空的字典,下面把百度翻译表单数据里面的参数都添加进去

data['from'] = 'auto'

data['to'] = 'auto'

data['query'] = input_shuru #把要翻译的内容赋值过来

data['transtype'] = 'translang'

data['simple_means_flag'] = '3'

#data需要用到urllib.parse.urlencode()函数进行编码

#注意 encode是进行编码 ,decode进行解码

data = urllib.parse.urlencode(data).encode('utf-8')

response = urllib.request.urlopen(req,data) #打开目标网站

html = response.read().decode('unicode_escape') #读取目标网站并解码成汉字(unicode_escape)

target = json.loads(html) #把上面的字符串结果用 json 封装成字典

print('翻译结果为',target['trans_result']['data'][0]['result'][0][1]) #输出结果应该看到的结果

上一篇: python爬虫之 URL的一般格式

下一篇: python标准库--logging模块

- openvpn linux客户端使用

52003

- H3C基本命令大全

51837

- openvpn windows客户端使用

42090

- H3C IRF原理及 配置

38941

- Python exit()函数

33444

- openvpn mac客户端使用

30388

- python全系列官方中文文档

29031

- python 获取网卡实时流量

24052

- 1.常用turtle功能函数

23977

- python 获取Linux和Windows硬件信息

22320

- LangChain1.0-Agent(进阶)大模型+Playwright实现网页自动化操作

28°

- LangChain1.0-Agent记忆管理

27°

- LangChain1.0-Agent接入自定义工具与React循环

58°

- LangChain1.0-Agent开发流程

59°

- LangChain1.0调用vllm本地部署qwen模型

93°

- LangChain-1.0入门实践-搭建流式响应的多轮问答机器人

107°

- LangChain-1.0入门实战-1

110°

- LangChain-1.0教程-(介绍,模型接入)

126°

- Ubuntu本地部署dots.ocr

544°

- Python搭建一个RAG系统(分片/检索/召回/重排序/生成)

2717°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江